La matière représente tout ce qui compose les êtres vivants (êtres humains, animaux, végétaux) et les systèmes ou objets inertes (air, eau, matériaux,...).

Par définition, tout ce qui n'est pas matière représente le vide absolu. Mais comment la matière est-elle formée ? Peut-on imaginer la matière dans le monde de l'infiniment petit ? Est-elle composée de vide ? Est-elle divisée ou composée d'une seule entité ?

Dès l'Antiquité, des penseurs grecs se sont posés ces questions qui n'ont trouvé des réponses seulement au cours des deux derniers siècles de notre ère.

Antiquité : deux concepts opposés

Vers - 400 avant Jésus Christ, certains philosophes grecs Leucippe puis son élève Démocrite se posent des questions sur la composition de la matière et pensent que celle-ci est formée de petites particules invisibles à l'oeil nu, qu'on ne peut diviser et séparées par du vide. Ces particules sont nommées à l'époque ἄτομος ou atome qui signifie « que l'on ne peut diviser ». Le mot atome vient donc de la pensée philosophique des grecs de l'antiquité. Bien sûr, les philosophes qui adhèrent à cette conception "atomiste" de la matière n'ont aucun moyen de la vérifier, les techniques scientifiques n'étant pas encore développées à l'époque. D'autres conceptions de la matière sont imaginées par d'autres philosophes. C'est le cas de la théorie des quatre éléments que développeront Héraclite, Empédocle et plus tard, Aristote à peu près à la même époque (environ 400 ans avant J.C.). Ce grand philosophe, aux idées scientifiques souvent erronées, pensait que toute la matière qui compose le monde et la nature est constitué des quatre éléments que sont : le feu, la terre, l'eau l'air. Autrement dit, n'importe quel objet peut être divisé en ces quatre éléments dans des proportions qui varient d'un objet à l'autre. Le penseur grec, en rejetant l'idée atomiste d'une matière constituée de petites particules, nie aussi, par la même occasion, l'existence du vide. Aristote était l'élève de Platon et a eu pour élève à son tour Alexandre le grand. Il avait donc une influence considérable sur son époque. En Europe, au cours des siècles suivants et cela, jusqu'à la Renaissance, Aristote a fait partie des philosophes les plus traduit tout simplement car ses idées philosophiques rejoignaient assez bien les écrits bibliques et les idées de l'Eglise catholique de toute l'époque moyenâgeuse. Jusqu'à la fin de la Renaissance, c'est donc une vision du monde "Aristotélicienne" sous le joug d'une Eglise catholique autoritaire qui prédomine dans le monde occidental pendant plusieurs siècles (voir histoire de la vision du monde).

La pression

La découverte du vide

La conception de la matière n'aurait pas évoluée si des expériences et des découvertes sur la pression n'avaient pas été effectuées par des grands savants de la Renaissance.

Le plus grand savant de la

Renaissance est sans hésitation Galileo Galilei dit

Galilée (1564-1642) connu pour ses travaux sur le mouvement et la

chute des corps, sur les instruments d'optique (lunette astronomique) pour

observer les étoiles et son soutien pour la théorie Copernicienne ce qui lui

vaudra un procès devenu célèbre.

A la Renaissance, époque où les fontaines italiennes jaillissaient de toutes part, les savants s'évertuaient à essayer d'élaborer des procédés de pompage de l'eau toujours plus performants. Devant ces attentes techniques, les expérimentations sur le pompage de l'eau allaient bon train. Galilée fut sollicité pour ces travaux d'ingénierie mais c'est son jeune ami Torricelli qui fit une découverte qui fut le point de départ d'une nouvelle branche de la physique, l'hydrostatique, qui allait mettre à mal la théorie des quatre éléments et les idées d'Aristote.

Evangelista Torricelli (1608-1647), qui suit de près et

étudie les travaux de son ami Galilée, s'intéresse donc au problème que les

fontainiers de Florence lui ont soumis : lorsque l'on pompe de l'eau, celle-ci

ne peut pas monter à une hauteur de plus de dix mètres. Le savant italien

répète donc l'expérience avec du mercure appelé à l'époque le "vif

argent". Celui-ci rempli de mercure un tube d'un mètre trente de long et

le place à la verticale dans un bac rempli du même liquide. Il constate alors

que le mercure, qui jusqu'alors remplissait tout le tube, descend jusqu'à une

hauteur de seulement 760

millimètres au dessus du niveau du mercure dans le bac.

Il remarque de plus que, quel que soit la hauteur du tube rempli de mercure au

départ, quel que soit la forme ou l'inclinaison de ce tube, la hauteur finale

de mercure dans le tube au-dessus du niveau du mercure dans le bac sera

toujours de 760 mm.

Si l'on prend un autre liquide, d'une densité différente (la densité représente la masse d'un objet

par rapport à son volume), la hauteur du niveau de ce liquide dans le tube sera

différente. Si l'on prend de l'eau, de densité bien inférieure au mercure, on

constate que ce liquide s'élève à dix mètres, mais pas plus, au grand désarroi

des fontainiers de l'époque. Autrement dit la hauteur d'un liquide dans un tube

verticale plongé dans un bac rempli de ce même liquide, diminue lorsque la

densité de ce liquide augmente. Les questions que se posent alors Torricelli et

de nombreux savants et ingénieurs de l'époque est : "pourquoi y a t-il une

hauteur limite de liquide dans un tube ?", qu'est-ce qui engendre cette

hauteur limite ?", " Pourquoi la hauteur d'un liquide dans un tube

dépend elle de sa densité ?" et " Qu'est ce qu'il y a entre la haut

du tube et le niveau supérieur de liquide dans le tube ?"

Evangelista Torricelli (1608-1647), qui suit de près et

étudie les travaux de son ami Galilée, s'intéresse donc au problème que les

fontainiers de Florence lui ont soumis : lorsque l'on pompe de l'eau, celle-ci

ne peut pas monter à une hauteur de plus de dix mètres. Le savant italien

répète donc l'expérience avec du mercure appelé à l'époque le "vif

argent". Celui-ci rempli de mercure un tube d'un mètre trente de long et

le place à la verticale dans un bac rempli du même liquide. Il constate alors

que le mercure, qui jusqu'alors remplissait tout le tube, descend jusqu'à une

hauteur de seulement 760

millimètres au dessus du niveau du mercure dans le bac.

Il remarque de plus que, quel que soit la hauteur du tube rempli de mercure au

départ, quel que soit la forme ou l'inclinaison de ce tube, la hauteur finale

de mercure dans le tube au-dessus du niveau du mercure dans le bac sera

toujours de 760 mm.

Si l'on prend un autre liquide, d'une densité différente (la densité représente la masse d'un objet

par rapport à son volume), la hauteur du niveau de ce liquide dans le tube sera

différente. Si l'on prend de l'eau, de densité bien inférieure au mercure, on

constate que ce liquide s'élève à dix mètres, mais pas plus, au grand désarroi

des fontainiers de l'époque. Autrement dit la hauteur d'un liquide dans un tube

verticale plongé dans un bac rempli de ce même liquide, diminue lorsque la

densité de ce liquide augmente. Les questions que se posent alors Torricelli et

de nombreux savants et ingénieurs de l'époque est : "pourquoi y a t-il une

hauteur limite de liquide dans un tube ?", qu'est-ce qui engendre cette

hauteur limite ?", " Pourquoi la hauteur d'un liquide dans un tube

dépend elle de sa densité ?" et " Qu'est ce qu'il y a entre la haut

du tube et le niveau supérieur de liquide dans le tube ?"

A cette dernière question, Torricelli postule l'existence du vide, remettant en avant un concept oublié depuis l'Antiquité avec Démocrite. En effet, jusqu'alors, les savants, encore influencés par les idées d'Aristote, ne croyaient pas à l'existence du vide, c'est à dire à un espace dénué de matière, adhérant ainsi à la fameuse phrase : "La nature a horreur du vide." Cependant, à la différence de Démocrite qui ne possédait aucun moyen de vérifier ses idées, Torricelli possède un atout majeur : la confirmation par l'expérience.En effet, lorsque l'on place le tube rempli de mercure à la verticale le niveau de ce liquide s'abaisse laissant un espace vide entre le haut du tube et le niveau de mercure. Qu'y a-t-il dans cet espace ? De l'air ou quelque autre matière invisible à l'oeil nu ? Impossibe : les parois du tube en verre ainsi que le mercure, empêchent toute matière de pouvoir combler cet espace lorsqu'il se forme.Cet espace n'a pu être comblé par une quelconque matière provenant de l'extérieur; de plus, aucune matière n'aurait pu se créer à l'intérieur du tube, comme par magie, à partir de rien. Torricelli vient de prouver au monde entier l'existence du vide par une expérience et vient de remettre en question une des idées sacrées d'Aristote selon laquelle le vide n'existait pas.

Attention à ne pas confondre le "vide" et le "rien". La physique moderne nous montre aujourd'hui que le vide possède une énergie, l'énergie du vide. On parle aussi, de pression du vide ou de vide quantique avec un phénomène appelé l'effet Casimir. Ainsi, le vide a une signification physique précise. Le mot "rien" est mot couramment utilisé et représente une notion trop abstraite pour avoir un sens physique.

Découverte de la pression atmosphérique

Blaise Pascal (1623-1662),

un philosophe, mathématicien et physicien français qu'on peut qualifier de

génie puisqu'il est entre autres l'inventeur de la première machine à calculer

(la pascaline) , le père des probabilités mathématiques et un des savants qui a

le plus contribué aux découvertes de la physique des fluides.

Blaise Pascal (1623-1662),

un philosophe, mathématicien et physicien français qu'on peut qualifier de

génie puisqu'il est entre autres l'inventeur de la première machine à calculer

(la pascaline) , le père des probabilités mathématiques et un des savants qui a

le plus contribué aux découvertes de la physique des fluides.

Pour expliquer le fait que le liquide à l'intérieur du tube ne s'écoule pas complètement dans le bac dans lequel il est plongé, Torricelli pense qu'il existe une force contenue dans l'air qui agit sur la surface du liquide contenu dans le bac, ce qui empêche le liquide du tube de descendre complètement. Pascal va plus loin puisqu'il est le premier à proposer le fait que l'air possède un poids, et donc une force, qui s'exerce sur tous les objets ainsi que sur la surface de tous les liquides.Le poids de l'air agissant sur la surface du liquide dans le bac équilibre donc le poids du liquide contenu dans le tube. C'est donc à cause de la force de l'air, et en particulier de son poids, que le liquide ne s'écoule pas complètement du tube. Pascal introduit donc la notion de pression atmosphérique pour rendre compte de la force de l'air s'exerçant sur tous les objets et systèmes physiques.

Invention du baromètre

Comme la pression varie en fonction du temps, cela signifie que la hauteur du mercure dans le tube de Torricelli est censé varier lui aussi. Lorsqu'il y a une dépression la hauteur de mercure dans le tube ne sera pas la même que lors d'un anticyclone. Le tube de Torricelli apparait donc comme un moyen de mesurer la pression atmosphérique. René Descartes, physicien, mathématicien et philosophe français a alors l'idée de placer une feuille de papier graduée derrière le tube pour mesurer précisément les variations de hauteur de mercure en fonction de la pression. La pression atmosphérique apparait donc comme une grandeur physique mesurable grâce au tube gradué de Torricelli bientôt baptisé baromètre.

L'unité de la pression

Sachant que l'air se raréfie avec l'altitude, Pascal pense alors que la pression de l'air devrait normalement aussi diminuer. Le 19 septembre 1648, il réalise alors cette expérience avec son beau-frère : il se place au sommet du Puy de Dôme puis au fond de la vallée en emportant un tube de Torricelli dans les deux cas. Ses prédictions sont alors confirmées : la hauteur de mercure dans le tube de Torricelli n'est pas la même au sommet du Puy de Dôme qu'au fond de la vallée. La pression atmosphérique diminue donc avec l'altitude et le tube de Torricelli est maintenant à disposition des scientifiques pour le prouver.

L'importance de l'expérience de Blaise Pascal conduit les scientifiques à accepter cette nouvelle grandeur physique, notée P, mesurable à l'aide du tube gradué de Torricelli (plus tard appelé baromètre). Chaque grandeur physique possède une unité. Il convient donc de choisir une unité pour la grandeur physique pression. Plusieurs unités seront utilisées : le torr ( 1 torr représente 1 mm de hauteur de mercure dans le tube de Torricelli), le Pascal (1 Pa = 1N/mètre carré), l'atmosphère (1 atm = 101 325 Pa), le bar (1 bar= 100 000 Pa). Il existe donc plusieurs unités pour la pression mais on utilise couramment aujourd'hui le bar (bar) et le pascal (Pa).

Il faut souligner la différence entre une pression et une force. La force est une grandeur physique dont l'unité est le Newton (N). La pression est une grandeur physique qui représente une force par unité de surface c'est à dire une force par mètre carré. Ce n'est donc pas tout à fait pareil. Et donc les unités non plus : le Newton pour une force, le Pascal pour une pression. De plus une force est mesurable à l'aide d'un dynamomètre, une pression à l'aide d'un baromètre.

La première pompe à vide

Deux années après la célèbre expérience de Pascal démontrant que la pression de l'air diminue avec l'altitude, un physicien allemand Otto Von Guericke met au point une machine permettant de faire le vide entre deux cylindres placés l'un sur l'autre : il s'agit de la première pompe à vide. Le principe est simple : on place deux hémisphère de cuivre (les hémisphères de Magdebourg) l'un sur l'autre et à l'aide d'une pompe, on enlève l'air contenu à l'intérieur du volume délimité par les deux cylindres. Normalement, si le vide est fait, il est impossible de séparer les deux hémisphères. En effet, si il n'y a plus d'air à l'intérieur, il n' y a donc plus de pression à l'intérieur des deux hémisphères. Par contre, la pression de l'air extérieur agit sur ces deux hémisphères. Si il y a une pression extérieure mais pas de pression à l'intérieur, les deux hémisphères ne peuvent se décoller. En 1663, Otto Von Guericke présente à la cour de Frédéric Guillaume I de Brandebourg, sa démonstration devenue célèbre. Après avoir extrait l'air à l'intérieur des deux hémisphères, ceux-ci sont alors attachés à des chevaux qui tirent de toutes leurs force de façons à les décoller. Impossible d'arracher l'un à l'autre les deux hémisphères même avec plusieurs chevaux en bonne santé ! : Von Guericke vient de mettre un terme aux débats philosophiques et scientifiques sur l'existence ou non du vide. Il confirme l'existence du vide dans l'expérience de Torricelli et balaye une bonne fois pour toute les idées d'Aristote sur l'inexistence du vide. La phrase : "La nature a horreur du vide" n'a plus aucun sens.

Le vide existe et fait partie intégrante de la nature.

Le modèle particulaire des fluides

Des expériences qui soulèvent des hypothèses

Après les découvertes scientifiques de la Renaissance sur la pression de l'air, de nombreux savants s'adonnent à des expériences sur les gaz comme l'air ou la vapeur d'eau.

Robert Boyle (1627-1691), un physicien, chimiste, philosophe irlandais perfectionne la machine de Von Guericke et fabrique une nouvelle pompe à air. De plus, celui-ci fait de nombreuses expériences sur les gaz et trouve une loi extrêmement intéressante appelée loi de Boyle-Mariotte (Mariotte étant un physicien français qui a découvert la même loi en même temps que Boyle). Cette loi stipule que, à température constante, si on augmente la pression d'un gaz, son volume diminue et si l'on diminue la pression d'un gaz, son volume augmente. De plus, le produit de la pression de ce gaz par le volume occupé par celui-ci est constant :

p1V1 = p2V2

Il s'agit de la première loi expérimentale empirique portant sur l'étude des gaz.

Mais ce qui est le plus important à retenir concernant Robert Boyle c'est l'interprétation et la conclusion que fait celui-ci après son étude sur les gaz. En effet, le scientifique irlandais stipule que la matière ,comme les gaz par exemple, est constitué de petites particules. Il rejette ainsi la théorie philosophique des quatre éléments d'Aristote adoptée par la communauté scientifique jusqu'à présent et donne raison à Démocrite et Leucippe qui avaient imaginé dès l'Antiquité, la matière constituée de petites particules.

Les débuts de la dynamique des fluides au siècle des lumières

Jusqu'au XVIIIè siècle, l'étude des fluides c'est à dire des gaz et des liquides appelée aussi la mécanique des fluides se limitait à une étude statique. Les lois découvertes concernant les fluides étaient valables pour des fluides fixes, ne se déplaçant pas ou très peu. Cette partie de la mécanique des fluides porte le nom de statique des fluides. Si l'on s'intéresse à l'eau, on parle d'hydrostatique. Au début du siècles des lumières, les scientifiques vont plus loin et s'intéresse à la deuxième partie de la mécanique des fluides : la dynamique des fluides, c'est à dire l'étude de leurs mouvements. Ces savants comme Daniel Bernoulli, Euler, Navier, D'Alembert vont se servir des avancées mathématiques et des découvertes de Newton, et en particulier sa théorie de la gravitation universelle, pour établir des lois physiques décrivant le déplacement des fluides.

Daniel Bernoulli (1700-1782) physicien suisse, découvre un théorème qui portera son nom : le théorème de Bernoulli. Ce théorème relie la vitesse d'un fluide, son altitude, sa densité volumique et sa pression.

Outre ce théorème extrêmement important, Bernoulli propose une explication de la pression en reprenant l'hypothèse de Boyle qui stipulait que les gaz était formés de particules. Mais Bernoulli va plus loin. Pour lui, les gaz sont effectivement constitués de petites particules en mouvement qui s'agitent et heurtent les parois du récipient qui les contient : la pression est le résultat de cette multitude de chocs. De plus, ces particules sont séparées par du vide, ce qui explique la loi de Boyle. En diminuant le volume de gaz, On diminue l'espace vide entre les particules donc les chocs sont plus fréquents et plus violents : la pression augmente. Si, au contraire, on augmente le volume du gaz, les chocs diminuent et la pression diminue. Si Bernoulli, tout comme Boyle n'a aucun moyen de vérifier ses dires par une observation directe de ces petites particules, l'hypothèse et le modèle particulaire des gaz séduit de nombreux scientifiques de par sa capacité à expliquer un grand nombre d'expériences. De plus, l'explication sur la pression et sur l'expérience de Boyle que donne Bernoulli sera mise en équation et inclue dans la théorie cinétique des gaz plus d'un siècle plus tard (voir la théorie cinétique des gaz un peu plus loin).

La décomposition de la matière par Lavoisier

Antoine-Laurent de Lavoisier (1743-1794) fut ce qu'on appelle le père de la chimie moderne. On le baptise souvent ainsi car il a jeté à plat de nombreuses croyances ésotériques de l'époque. En effet, encore du temps de Lavoisier c'est à dire il y a un peu plus de deux siècles seulement, une grande partie de la science était associée à des phénomènes quasi-divins, à des nombres symboliques, à des croyances obscurantistes provenant du Moyen-Age. On ne parlait pas à proprement parler de chimie mais d'alchimie, qui relevait plutôt du domaine du mystique que de la science.

Ce savant français disposait d'un laboratoire avec de nombreux instruments. Ce laboratoire est d'ailleurs présenté au merveilleux musée des arts et métiers à Paris. On peut ainsi comprendre pourquoi Lavoisier a marqué une rupture avec les anciennes méthodes : l'utilisation d' outils extrêmement précis et l'application de méthodes très rigoureuses.

La loi de conservation de la masse

Une des croyance mystique de l'époque à laquelle la plupart des savants adhéraient était la théorie phlogistique. La phlogistique était une sorte de fluide présente à l'intérieur de tous les objets qui s'échappait sous forme de chaleur lors de la combustion de ceux-ci. La perte de la masse des objets lors de leur combustion était donc expliquée par la perte de la phlogistique inhérente à tous ces objets. Georg Ernst Stahl, le père fondateur de cette théorie complètement fausse l'expliquait ainsi : " Le phlogistique est du feu fixé dans la matière et qui s'en échappe lors des combustions." Lavoisier qui travaillait beaucoup sur les combustions, s'est aperçu qu'un objet n'a pas besoin de phlogistique intérieur pour brûler mais plutôt de dioxygène, gaz invisible consommé pendant la combustion. Celui-ci dresse alors des bilans de combustion en mesurant précisément les volumes et les masses des espèces présentes en début de réaction, les réactifs, et des espèce apparaissant au cours de la réaction, les produits. Par ses nombreuses mesures extrêmement rigoureuses et précises, Lavoisier arrive à cette conclusion assez impressionnante : Lors d'une réaction chimique, comme une combustion par exemple, la masse totale des réactifs (espèces présentes en début de réaction) est égale à la masse totale des produits (espèces présentes en fin de réaction). Tout le monde connait ainsi cette citation célèbre de Lavoisier :

"Rien ne se perd, rien ne créé, tout se transforme"

Lavoisier vient de démontrer un des plus grands principes de la physique et

de la chimie : La conservation de la masse lors d'une transformation ou

réaction chimique. Par ce principe, il détruit la théorie de la

phlogistique et remet en cause la théorie des quatre éléments d'Aristote.En effet,

lors des réactions chimiques étudiées par Lavoisier, celui-ci est convaincu que

les réactifs, lorsqu'il réagissent entre eux, se décomposent en éléments

simples avant de se recomposer différemment entre eux pour former les produits.

Autrement dit, les éléments qui composent les réactifs sont les mêmes que ceux

qui composent les produits mais agencés différemment. Lors de la

transformation, aucun élément ne se perd, aucun élément ne se créé mais

l'assemblage de ceux-ci change transformant ainsi les réactifs en produits.

Pour Lavoisier, ces éléments simples sont nombreux et dénombrables mais

sûrement pas au nombre de quatre à savoir le feu, la terre, l'eau et l'air.

Lavoisier vient de démontrer un des plus grands principes de la physique et

de la chimie : La conservation de la masse lors d'une transformation ou

réaction chimique. Par ce principe, il détruit la théorie de la

phlogistique et remet en cause la théorie des quatre éléments d'Aristote.En effet,

lors des réactions chimiques étudiées par Lavoisier, celui-ci est convaincu que

les réactifs, lorsqu'il réagissent entre eux, se décomposent en éléments

simples avant de se recomposer différemment entre eux pour former les produits.

Autrement dit, les éléments qui composent les réactifs sont les mêmes que ceux

qui composent les produits mais agencés différemment. Lors de la

transformation, aucun élément ne se perd, aucun élément ne se créé mais

l'assemblage de ceux-ci change transformant ainsi les réactifs en produits.

Pour Lavoisier, ces éléments simples sont nombreux et dénombrables mais

sûrement pas au nombre de quatre à savoir le feu, la terre, l'eau et l'air.

La théorie des quatre éléments d'Aristote est alors complètement mis en défaut par Lavoisier grâce à deux expériences extrêmement célèbres : la découverte de la composition de l'air et la décomposition de l'eau en éléments simples.

La composition de l'air

En 1776, le chimiste français effectue une expérience pour découvrir la composition de l'air. Il découvre que l'air est un mélange de deux gaz. Il découvre en plus leur proportions respectives : 20% de dioxygène et 80% de diazote. L'air est donc composé de deux substances, ce n'est donc pas un élément simple comme la théorie des quatre éléments le postulait.

La décomposition de l'eau

Quelques année plus tard, Lavoisier effectue la décomposition de l'eau. Il montre que l'eau est en fait composée de deux éléments : l'hydrogène et l'oxygène. Comme pour l'air, l'eau n'est donc pas un élément simple mais une substance composée de deux éléments que sont l'oxygène et l'hydrogène.

Cinq ans après la révolution française, Antoine-Laurent de Lavoisier fut guillotiné par le régime de la Terreur, tant peut être pour ses avancées en sciences que pour son appartenance à une certaine classe sociale, ou les deux. Toujours est -il qu'il n'avait que cinquante et un an et encore beaucoup de choses à découvrir si ce génie n'avait pas perdu la tête aussi tôt. Louis de Lagrange (1736-1813), grand mathématicien et physicien français ayant travaillé avec Lavoisier sur l'élaboration d'un système métrique, aurait prononcé ces paroles à la mort du plus grand chimiste français : "Il ne leur a fallu qu'un moment pour faire tomber cette tête et cent années, peut-être, ne suffiront pas pour en reproduire une semblable."

Des théories pour expliquer

John Dalton (1766-1844) est un physicien et chimiste britannique connu pour ses travaux sur la daltonisme (d'où le nom) dont il souffrait lui-même. Il est aussi connu pour sa contribution à la thermodynamique et à l'étude des gaz. Sa loi célèbre (loi de Dalton) stipule que la pression totale d'un mélange de plusieurs gaz dans un certain volume est la somme des pressions de chaque gaz si ils occupaient seuls le même volume. A la même époque, Louis-Joseph Gay-Lussac (1778-1850), savant français propose une autre loi portant sur les gaz. Celle-ci stipule que le rapport des volumes de gaz différents est égal au rapport de leur températures.

Dalton, en se servant des expérience et conclusions de Lavoisier, en se servant des travaux et hypothèses de Bernoulli sur la composition particulaire des gaz, publie en 1805 une théorie atomiste. De par cette théorie, celui-ci affirme que la matière est composée de minuscules particules élémentaires indivisibles. Il existe différents types de particules. Chaque type de particule possède sa propre masse. Celles-ci peuvent s'assembler entre elles en respectant certaines proportions simples pour former les composés que nous connaissons. Dalton continue donc sur la lancée de Démocrite, Boyle, Bernoulli et Lavoisier. Celui-ci publie alors de nombreux résultats d'expériences pour étayer sa théorie. Il procède de plus à répertorier les éléments selon leur masse, leur masse atomique.

Si Dalton a contribué de manière extrêmement importante à l'avancée de la chimie moderne, celui-ci fait une erreur lors du calcul des masses atomique et la classification de ceux-ci : certaines particules élémentaires s'assemblent entre elles pour former des particules un peu plus massiques et non élémentaires car décomposables. L'erreur de Dalton a été en fait de considérer comme atomes des molécules, particules elles-mêmes constituées d'atomes.

Cette distinction entre atomes et molécules sera proposée par Amedeo Avogadro (1776-1856) , philosophe, chimiste et physicien italien. Il suppose donc qu'il existe des particules constituées elles-mêmes d'autres particules élémentaires. Un peu plus tard, on distinguera les particules composées des particules élémentaires par les mots "molécules" et "atomes". Ainsi, selon, Avogadro, les gaz sont constituées de molécules, particules microscopiques en mouvement constant, qui sont elles-mêmes constituées d'autres particules indivisibles et élémentaires appelées atomes.

Se servant des lois de Dalton et de Gay-Lussac, Avogadro propose alors une hypothèse restée célèbre : "Des volumes égaux de gaz différents pris dans les mêmes conditions de températures et de pression possèdent le même nombre de molécules."

Des toutes ces lois, se dégagera une autre loi, une des plus célèbres de la thermodynamique, la loi des gaz parfaits :

pV = nRT

où p représente la pression d'un gaz en Pascal (Pa) , V son volume en mètre cube, R est une constante (= 8,314 SI), T est la température du gaz en degré Kelvin (K) et n est le nombre de moles de gaz (voir paragraphe suivant)

La mole, une quantité de matière

Une mole de matière (fluides ou solides) représente le nombre d'atomes présents dans 12 grammes de carbone 12, c'est à dire 6,022 x 10^23 entités. On appelle entités les atomes, molécules, ions (voir plus loin concernant l'explication des ions) constituant la matière considérée. Une mole est ainsi une quantité de matière égale à 6,022 x 10^23 entités. 6,022 x 10^23 est appelé le nombre d'Avogadro. La mole a été introduite pour simplifier les choses et éviter d'utiliser des nombres trop grands, ce qui est long et risqué lors de calculs. Ainsi, si un gaz possède 6,022 x 10^23 molécules on dira pour simplifier qu'il possède une mole de matière. Si le gaz possède 12, 044 x 10^23 molécules, ce qui représente le double, celui-ci est alors composé de deux moles de matière. Une mole est donc un "paquet" contenant un nombre fixé et égal à 6,022 x 10^23 entités. A masse égale, deux gaz différents ne contiennent pas le même nombres de molécules, donc d'entités et par conséquent ont un nombre de moles de matière différents. Par exemple un gramme de dioxygène contiendra moins de molécules de dioxygène qu'un gramme de diazote contiendra de molécules de diazote. Pour un gramme de chaque gaz, le dioxygène contiendra donc moins de quantité de matière donc moins de moles que le diazote.

Au supermarché si l'on considère pour simplifier de raisonner en "paquet" de douzaines, une douzaine d'oeufs contiendra le même nombre d'entités qu'un paquet d'une douzaine de citrouilles : à chaque fois nous avons douze entités. Cependant, dans un kilogramme de citrouilles il y a moins de citrouilles qu'il n'y a d'oeufs dans un kilogramme d'oeufs. A masse égale, il y a donc moins de quantité de matière de citrouilles que de quantité de matière d'oeufs. C'est un peu le même principe avec les moles.

La théorie cinétique des gaz

Au milieu du XIXème siècle, deux grands mathématiciens et physiciens,

Ludwig Boltzmann (autrichien 1844-1906) et James Clerk Maxwell

(écossais 1831-1879), décident d'expliquer toutes les lois empiriques

découvertes sur le comportement des fluides, et en particulier des gaz, à

l'aide d'une théorie globale et universelle. Boltzmann et Maxwell partent de

l'hypothèse que les gaz sont constitués de particules microscopiques. A partir de cette

hypothèse, les deux génies vont bâtir une théorie qui décrit le mouvement de

ces particules en se servant de la théorie de la mécanique des corps élaborée

par Newton un siècle plus tôt qui décrit le mouvement des objets sur terre et

dans l'espace. Ainsi, Maxwell et Boltzmann considèrent que les particules,

possédant une masse, obéissent donc aux lois de la gravitation universelle. On

peut donc décrire leurs mouvements et leurs interactions. Comme l'étude porte

en général sur un nombre important de particules en raison de leur petite

taille, Maxwell, Boltzmann construisent une théorie mathématique s'appuyant sur

des calculs statistiques : la physique ou mécanique statistique est née. Cette

nouvelle physique décrit donc le mouvement des particules extrêmement petites

comme les molécules, les ions ou le atomes. En ce qui concerne l'étude du

mouvement des molécules d'un gaz, cette physique statistique prend le nom de théorie

cinétique des gaz. Cette théorie a une portée énorme et apparait comme

un outil extrêmement puissant puisque ce modèle imaginé et mis en équation

permet alors d'expliquer toutes les lois expérimentales découvertes sur les gaz

comme la loi du gaz parfait et permet aussi d'expliquer les notions de pression

et de température. Ainsi, la pression apparait comme le résultats de tous les

chocs des particules contre les parois d'un récipient et la température comme

le degré d'agitation des molécules, à savoir leurs vitesses et la fréquence des

chocs. La théorie cinétique des gaz permet alors de calculer grâce à des

calculs statistiques, la pression et la température d'un gaz à partir de

considérations microscopiques!

Au milieu du XIXème siècle, deux grands mathématiciens et physiciens,

Ludwig Boltzmann (autrichien 1844-1906) et James Clerk Maxwell

(écossais 1831-1879), décident d'expliquer toutes les lois empiriques

découvertes sur le comportement des fluides, et en particulier des gaz, à

l'aide d'une théorie globale et universelle. Boltzmann et Maxwell partent de

l'hypothèse que les gaz sont constitués de particules microscopiques. A partir de cette

hypothèse, les deux génies vont bâtir une théorie qui décrit le mouvement de

ces particules en se servant de la théorie de la mécanique des corps élaborée

par Newton un siècle plus tôt qui décrit le mouvement des objets sur terre et

dans l'espace. Ainsi, Maxwell et Boltzmann considèrent que les particules,

possédant une masse, obéissent donc aux lois de la gravitation universelle. On

peut donc décrire leurs mouvements et leurs interactions. Comme l'étude porte

en général sur un nombre important de particules en raison de leur petite

taille, Maxwell, Boltzmann construisent une théorie mathématique s'appuyant sur

des calculs statistiques : la physique ou mécanique statistique est née. Cette

nouvelle physique décrit donc le mouvement des particules extrêmement petites

comme les molécules, les ions ou le atomes. En ce qui concerne l'étude du

mouvement des molécules d'un gaz, cette physique statistique prend le nom de théorie

cinétique des gaz. Cette théorie a une portée énorme et apparait comme

un outil extrêmement puissant puisque ce modèle imaginé et mis en équation

permet alors d'expliquer toutes les lois expérimentales découvertes sur les gaz

comme la loi du gaz parfait et permet aussi d'expliquer les notions de pression

et de température. Ainsi, la pression apparait comme le résultats de tous les

chocs des particules contre les parois d'un récipient et la température comme

le degré d'agitation des molécules, à savoir leurs vitesses et la fréquence des

chocs. La théorie cinétique des gaz permet alors de calculer grâce à des

calculs statistiques, la pression et la température d'un gaz à partir de

considérations microscopiques!

Il convient de souligner le génie de ces deux physiciens hors pair. D'une part, Au milieu du XIXème siècle et jusqu'au début du XXème siècle, un grand nombre de physicien célèbres sont hostiles au modèle particulaire des gaz et de la matière. Dans un monde scientifique encore sceptique et hostile et sans même pouvoir observer les particules d'un gaz, Maxwell et Boltzmann ont imaginé et décrit leurs mouvements et leurs interactions grâce aux mathématiques, révolutionnant ainsi la physique et inventant une nouvelle branche de celle-ci, la physique statistique. Outre le fait d'avoir contribué à cette révolution de la physique des particules, Maxwell a participé en même temps a une autre révolution scientifique puisque c'est lui qui a élaboré une théorie mathématique unifiant les phénomènes électriques et les phénomènes magnétiques. Les quatre lois mathématiques expliquant tous les phénomènes électromagnétiques portent ainsi le nom des quatre lois de Maxwell.

Boltzmann quant à lui à continuer à élaborer la physique statistique. En effet, certains phénomènes comme l'entropie, sorte de désordre qu'on observe à l'échelle macroscopique, ne pouvaient être expliquées jusqu'alors par la théorie statistique. Boltzmann va alors développer celle-ci et proposer d'autre lois et équations probabiliste comme la loi de distribution des énergies, le principe d'équipartition de l'énergie ou encore la célèbre formule donnant une interprétation statistique de l'entropie S = k log W. Comme nous l'avons déjà vu, le point de vue atomiste et le fait de vouloir "découper" la matière en particules microscopiques qui suivraient des lois aléatoires et probabilistes n'était pas partagé par beaucoup de physiciens de l'époque. Jamais jusqu'alors la nature n'avait été considéré comme obéissant à des règles probabilistes et de hasard. Les considérations et les avancées de Boltzmann ont ainsi suscité de violentes critiques à son égard. On pense que celui-ci s'est suicidé à l'âge de 62 ans à cause justement de l'incompréhension de ses contemporains face à son génie. On ne peut que lui rendre hommage puisqu'on ne peut imaginer la physique actuelle sans l'apport de la physique statistique. Celle-ci a révolutionné des domaines comme une grande partie de la physique comme la thermodynamique, la mécanique des fluides, la physique des semi-conducteurs mais aussi la chimie, la biologie et la théorie de l'information. Les aspects probabilistes et aléatoires de cette théorie ont par ailleurs apporté une nouvelle manière de penser et d'aborder les phénomènes microscopiques qui ont servi à bâtir la physique quantique.

Le mouvement Brownien

Le mouvement brownien constitue la seule "preuve observable" du XIXème siècle de la constitution de la matière par des molécules et atomes. Il a été observé en 1827 par Robert Brown (1773-1858) alors que celui-ci observait au microscope le mouvement d'une particule dans le fluide situé à l'intérieur d'un grain de pollen. Le botaniste écossais s'est aperçu que cette particule microscopique mais observable au microscope suivait un mouvement aléatoire constitué de lignes droites constamment déviées soit par les parois du grain de pollen soit le plus souvent par une multitude d'obstacles invisibles. Pourquoi donc cette particule visible au microscope subit-elle des chocs contre ces barrières invisibles ?

Trajectoire de la particule soumise au mouvement brownien :

Certains physiciens y voient là une formidable confirmation de la théorie cinétique des gaz. En effet, des savant émettent alors l'hypothèse que la particule est constamment déviée car elle subit des chocs avec les molécules constituant le fluide. Ces molécules sont tellement petites qu'on ne peut les observer même au microscope mais on peut observer l'effet de ces molécules sur une particule beaucoup plus grosse observable au microscope. C'est la théorie qu'avancera un des plus grands génies de la physique, Albert Einstein (1979-1955). En 1905, celui-ci publie une explication théorique du mouvement brownien en fonction du mouvement aléatoire des molécules et y énonce notamment une formule mathématique importante. A l'aide de cette formule, un physicien français, Jean Perrin (1870-1942), en 1908, retrouva par le calcul, le nombre de molécules contenues dans une mole de matière et ainsi confirmer le nombre d'Avogadro! La théorie d'Einstein et l'explication du mouvement brownien rejoint et confirme donc la théorie cinétique des gaz et des fluides. Pour prendre un seul exemple, on remarque que lorsqu'on augmente la température à l'intérieur du grain de pollen , la particule observée au microscope est déviée beaucoup plus rapidement et plus violemment ce qui signifie que les molécules sont de plus en plus agitées et multiplient les chocs. C'est exactement ce que stipule la théorie cinétique des gaz.

L'atome

La transition entre le XIXième siècle et le XXième siècle c'est à dire il y a à peu près cent ans, est marquée par l'adhésion quasi-unanime avec une hypothèse qu'avait soulevé Démocrite environ 300 année avant J.C. Il aura donc fallu attendre environ 2200 ans pour confirmer l'hypothèse atomiste de l'Antiquité évoquée par ces penseurs grecs.

Cette vision atomiste de la matière a été une des vision les plus longtemps controversée tout simplement parce que la vision microscopique ou plutôt "nanoscopique" des objets nous est impossible. Nos perceptions sont limitées, notre oeil, aidé par le microscope peut discerner des cellules d'êtres vivants, des bactéries mais ne peut aller au-delà. C'est donc la limite des perceptions humaines qui a empêché le physicien de comprendre et d'appréhender la composition de la matière pendant de nombreux siècles. Le XXème siècle marque d'ailleurs le début de la "physique moderne" dans le sens où les scientifiques grâce à leurs outils très perfectionnés, grâce à des mathématiques de plus en plus efficaces vont perfectionner leur manière de "voir" les choses indiscernables. Le savant du XXème siècle a de plus conscience d'une chose : la nature est complexe et surprenante. Il se peut qu'en dehors de nos perceptions, elle ne se comporte pas du tout comme on l'avait imaginée ou comme on le croyait jusqu'à présent. Tout au long du XXème siècle, les scientifiques seront constamment obligés de remettre en question non seulement les visions et théories "classiques" des siècles précédents mais aussi leurs idées et théories qui se succèdent alors. Au fur et à mesure de ces remises en questions, la physique "non observable" va progresser de manière spectaculaire que ce soit en astrophysique avec le mouvement des galaxies et l'étude de l'univers ou que ce soit en physique des particules et des atomes.

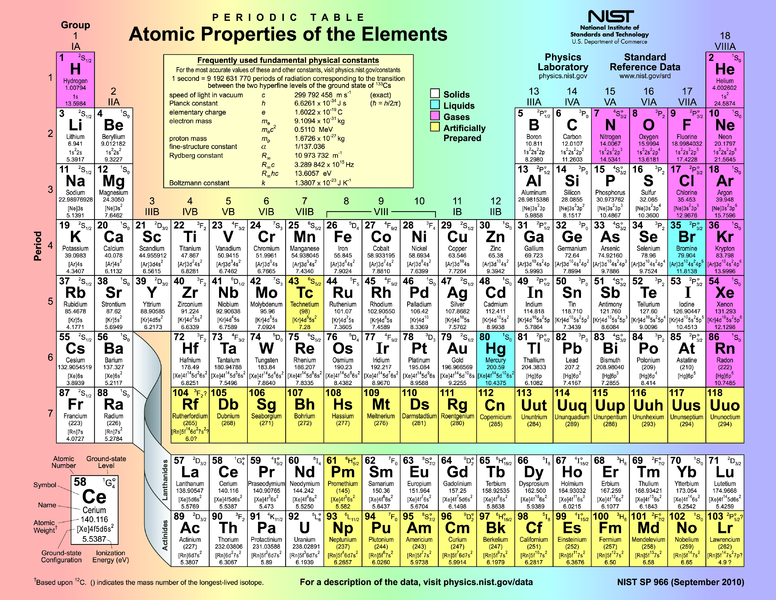

Le tableau périodique de Mendeleïev

En cette fin houleuse du XIXème siècle où la notion d'élément ou d'atome n'est toujours pas acceptée par tous, Dmitri Mendeleïev (1834-1907), savant russe, va reprendre le concept d'Avogadro selon laquelle les éléments chimiques peuvent être classés selon certaines propriétés, par exemple, leur masse atomique. L'erreur d'Avogadro avait été de confondre atomes et molécules. Maintenant, il s'agit de classer les atomes appelés éléments dans le sens où ce sont des particules indivisibles et élémentaires. Une molécule étant composée d'atomes ce n'est donc pas un élément indivisible. On peut donc la décomposer en éléments ou atomes.

En étudiant la masse atomique des atomes découverts, ainsi que les propriétés physicochimiques de ces éléments, Mendeleïev va élaborer un tableau de classification des éléments : le tableau de classification périodique des éléments. En effet, celui-ci découvre que l'ensemble des atomes respectent plusieurs règles importantes : les éléments possédant des masses atomiques voisines possèdent souvent les mêmes propriétés physicochimiques. Il découvre aussi qu'il existe une périodicité dans l'évolution des masses atomiques au niveau des propriétés physicochimique des éléments. Ainsi chaque colonne du tableau périodique contient des éléments ayant des propriétés physicochimiques équivalentes. Dans cette colonne les éléments qui se succèdent possèdent des masses atomiques qui se suivent selon une certaine périodicité. De plus, il établit un lien entre l'évolution de la masse atomique et le nombre de liaisons que peut établir un élément avec d'autres éléments : c'est la valence. Au contraire d'une colonne où le nombre de liaisons que peut établir un atome et la même pour tous les éléments, sur une ligne, ce nombre de liaisons possibles pour les atomes évolue.

Le fait de pouvoir classer les éléments dans un tableau montre plusieurs choses importantes. Tout d'abord, les différents types atomes sont en nombre limité. C'est leurs nombre infini d'arrangements possibles entre eux qui structure une possible infinité d'objets matériels. Ensuite, ce tableau montre que les atomes respectent des règles bien établies et le plus souvent périodiques. C'est là que se situe le caractère extraordinaire du monde qui nous entoure et qui nous compose : aussi bien dans l'infiniment grand que dans l'infiniment petit, la nature obéit à des règles strictes. Le physicien est là pour les trouver. Mendeleiev fut donc l'un des premiers à avoir établi des règles empiriques (basées sur l'expérience) auxquelles étaient sensés obéir les atomes. Il s'ensuit de ces premières règles une spécificité importante commune à toutes les lois, règles et théories : la prédiction. En effet, lors de sa classification, Mendeleiev et les savants de son époque savaient qu'il existait un nombre de types d'atomes limité mais étaient loin de les connaitre tous. En élaborant le tableau périodique, Mendeleiev s'est aperçu que les différents atomes connus étaient loin de la remplir complètement. Celui-ci comportait des "trous", des emplacements libres à l'image d'un puzzle qui n'est pas fini et à qui il manque des pièces. Le tableau respectant une certaine périodicité de la masse atomique, à chacun des emplacements libres, correspondait une masse atomique bien précise et donc des propriétés physicochimiques bien précises. Par exemple, Mendeleiev découvre trois "cases manquantes dans son tableau. Non seulement il prédit alors l'existence de trois atomes non découverts correspondants à ces emplacements vides, mais il décrit leurs propriétés physicochimiques avant même qu'ils soient découverts.

Entre 1875 et 1886, alors que peu de scientifiques adhéraient aux idées de Mendeleiev, ces trois atomes "manquants" sont découverts et nommés gallium, scandium et germanium.De plus, l'étude de ces trois nouveaux éléments montre que leurs propriétés physicochimique rejoignent complètement les propriétés qu'avait prédit Mendeleïev. La classification périodique de Mendeleïev rencontre alors un succès énorme.

Au cours de la fin du XIX siècle et au cours du XXème siècle, de nouveaux atomes seront découverts et viendront combler les "cases vides" du tableau. Le nombre d'éléments connus passe d'une soixantaine à l'époque des débuts de Mendeleïev jusqu'à cent dix-huit aujourd'hui :

Au cours du XXème siècle, avec l'avènement et le succès de la physique quantique, le tableau périodique sera complété, arrangé et surtout expliqué grâce à des règles extrêmement rigoureuses (voir paragraphe sur les débuts de la physique quantique).

Le modèle de Thomson et l'électron

Comme l'atome n'est toujours pas observable par les yeux du physicien, ce début du XXème siècle sera marqué par la succession de modèles théoriques proposés par des scientifiques suite à des découvertes expérimentales importantes.

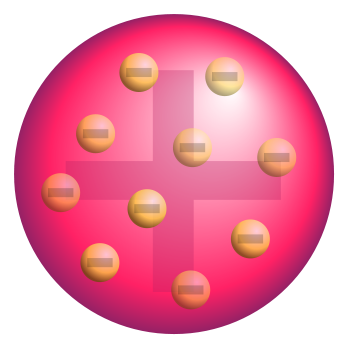

La première découverte importante faite sur l'atome est effectuée en 1897, où un physicien anglais, Joseph John Thomson (1856-1840), découvre avec son expérience sur les rayons cathodiques, que l'atome est constitué de particules encore plus petites et de charges négatives : les électrons. Les atomes sont donc divisibles et n'apparaissent plus comme élémentaires!

Fort de sa découverte, Thomson propose quelques années plus tard, un modèle décrivant la composition de l'atome. Il stipule que l'atome est composé d'une sorte de "soupe" de charges positives dans laquelle sont baignées des charges négatives : les électrons.

Si l'on veut imaginer le modèle de Thomson, on se sert souvent de l'image du

pudding dans lequel se trouvent des grains de raisins ou des prunes.

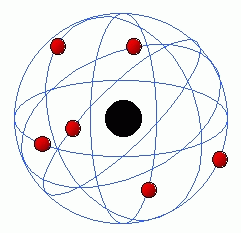

Rutherford : un modèle planétaire

En 1909, Ernest Rutherford (1871-1937), réalise une expérience qui va révolutionner le concept d'atome. Celui-ci, avec son équipe, bombarde une fine feuille d'or de 0,6 micromètreS d'épaisseur par des particules alpha émises par une source radioactive de radium. Ces particules alpha sont des atomes d'hélium à qui on a enlevé deux électrons. Sachant qu'elles ont donc deux charges négatives en moins, ces particules qu'on appelle des ions, possèdent donc deux charges positives excédentaires. Il faut souligner aussi que la taille de ces ions provenant d'atomes d'hélium est bien inférieure à la taille des atomes d'or. Ce que Rutherford veut savoir c'est ce qui se passe lorsque ces petites particules alpha rencontrent les atomes de la feuille d'or. il dispose donc autour de la feuille d'or un ruban fluorescent pour détecter le point d'impact des particules alpha après leur interaction avec la feuille d'or, et donc connaitre leurs trajectoires.

Rutherford constate alors que la grande majorité des particules alpha ont

traversé la feuille d'or sans être déviées. Il remarque qu'une minorité de

particules sont déviées dont quelques unes qui sont déviées vers l'arrière.

Qu'est-ce que cela signifie ? Pour Rutherford, la réponse est claire : la majeure partie des particules alpha ayant suivi une ligne droite et n'ayant pas été déviées, cela signifie qu'elles n'ont rencontré que ... du vide. Pourtant, dans un solide, les atomes sont liés les uns aux autres et présentent un aspect compact selon la théorie. En fait, ce n'est pas l'espace entre les atomes qui est important de considérer ici mais l'espace à l'intérieur des atomes ! Rutherford émet donc l'idée que les atomes constituant un solide sont bien liés entre eux mais chacun d'entre eux est constitué majoritairement de vide ! Ce que traversent les particules alpha, c'est donc le vide à l'intérieur des atomes!

En 1911, Rutherford propose alors le modèle

suivant : les atomes sont constitués d'un noyau central concentrant

presque toute la masse de l'atome. Autour de ce noyau, "gravitent"

des électrons qui se déplacent autour du noyau comme des planètes autour du

soleil. Entre le noyau et les électrons comme entre les planètes et le soleil :

un énorme espace constitué de ... vide absolu. Cela signifie une chose pour les

scientifiques : comme toute la matière est constituée d'atomes et que les

atomes sont constitués majoritairement de vide, la nature n'est donc constituée

pratiquement que de vide ! D'après les calculs du scientifique, le noyau de

l'atome serait 100 000 fois plus petit que l'atome entier. Cela signifie que si

le noyau faisait 8

centimètres de diamètre, l'atome, lui, ferait 8 kilomètre de diamètre

! Le dernier électron qui délimiterait l'atome aurait donc une orbite de 8 kilomètre de diamètre

autour d'un noyau qui n'aurait pour diamètre seulement 8 centimètres. Le

reste ne serait composé que de vide et d'autres électrons.

En 1911, Rutherford propose alors le modèle

suivant : les atomes sont constitués d'un noyau central concentrant

presque toute la masse de l'atome. Autour de ce noyau, "gravitent"

des électrons qui se déplacent autour du noyau comme des planètes autour du

soleil. Entre le noyau et les électrons comme entre les planètes et le soleil :

un énorme espace constitué de ... vide absolu. Cela signifie une chose pour les

scientifiques : comme toute la matière est constituée d'atomes et que les

atomes sont constitués majoritairement de vide, la nature n'est donc constituée

pratiquement que de vide ! D'après les calculs du scientifique, le noyau de

l'atome serait 100 000 fois plus petit que l'atome entier. Cela signifie que si

le noyau faisait 8

centimètres de diamètre, l'atome, lui, ferait 8 kilomètre de diamètre

! Le dernier électron qui délimiterait l'atome aurait donc une orbite de 8 kilomètre de diamètre

autour d'un noyau qui n'aurait pour diamètre seulement 8 centimètres. Le

reste ne serait composé que de vide et d'autres électrons.

Le modèle de Rutherford appelé aussi modèle planétaire remporte un succès considérable à l'époque. Les scientifiques y voient là un formidable moyen d'expliquer le fonctionnement de toute la nature. En effet, dans l'infiniment petit avec les atomes comme dans d'une étoile comme les électrons tournent autour d'un noyau, à la seule différence que les forces ne sont pas de la même nature (gravitationnelles pour les planètes, électromagnétiques pour les électrons). Qu'importe : les méthodes mathématiques de résolution d'un système gravitationnel et d'un système électromagnétique sont pratiquement les mêmes.

La physique classique triomphe ainsi de la nature : l'homme peut expliquer le

comportement des plus petits objets constituant la nature (électrons et atomes)

comme celui des plus grands (planètes, étoiles).

Seulement voilà : la beauté et le mystère de la nature sont infinies tout comme

l'humilité de l'espèce humaine. La conception de Rutherford même si elle

séduit, possède de sérieuses limites. En effet, d'après la théorie, si une

particule chargée est uniformément accélérée, comme l'électron autour du noyau,

celle-ci rayonne de l'énergie sous forme de lumière. L'électron doit ainsi

perdre de l'énergie sous forme de rayonnement. De plus, au fur et à mesure que

celui-ci perd de l'énergie, l'orbite de celui-ci diminue de diamètre. Au bout

d'un moment, en toute logique, l'électron doit tomber sur le noyau et provoquer

la destruction de l'atome. Or, à part les atomes radioactifs, tous les atomes

sont stables.

Le modèle planétaire doit donc être abandonné et remplacé par un autre.

En ce début de XXème siècle, c'est non seulement un modèle qui sera abandonné au profit d'un autre mais aussi d'une manière plus générale, cela va marquer la fin de la "physique classique" et l'apparition de la "physique moderne" qui fait appel à de nouveaux concepts et de nouvelles manières de "penser la physique" comme l'avènement de la physique quantique.

Il faut tout de même souligner plusieurs remarques : tout d'abord, la physique

classique de Newton, Maxwell et les autres est toujours très utilisée pour les

nombreuses situations où elle est toujours valable. Elle n'est donc pas

"fausse" mais limitée, et donc complétée par la physique moderne du

XXème siècle (relativité générale, physique quantique, théorie des cordes).

Ensuite, pour revenir à Rutherford, il faut reconnaitre que son modèle n'est

pas complètement faux du tout. Les électrons se trouvent bien en dehors du

noyau, et le vide est prépondérant dans un atome entre les électrons et le

noyau atomique. De plus, ses calculs sur les dimensions de l'électron et du

noyau étaient assez justes. C'est la trajectoire et le comportement des

électrons tels que les définissait Rutherford qui posait problème avec la

théorie classique.

Les débuts de la physique quantique : le modèle de Bohr

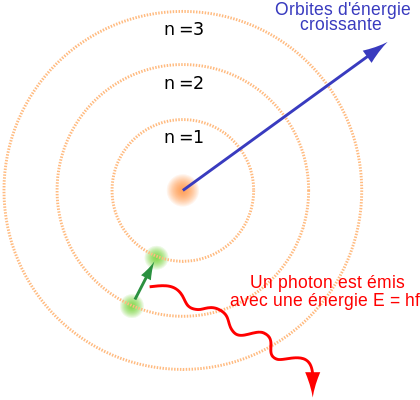

En 1913, Niels Bohr (1885-1962), un physicien danois propose un nouveau modèle pour décrire l'atome. Celui-ci se sert à la fois du modèle planétaire proposé par Rutherford deux années plus tôt ainsi que la théorie des quanta de Max Planck et d'Einstein qui stipule que la lumière et la matière s'échangent de l'énergie par "paquets bien quantifiés". Bohr reprend ainsi certains aspects du modèle de Rutherford en imaginant les électrons occupant des orbites autour du noyau. Mais ces électrons suivent des règles bien déterminées. Ainsi, il ne peut pas exister une quantité infinie d'électrons sur une orbite. De plus, à chaque orbite correspond une énergie électronique bien déterminée. Ces orbites électroniques apparaissent ainsi comme des niveaux d'énergie. Les électrons se déplacent sur les orbites mais ne rayonnent pas. Ils sont stables. Cependant, lors d'une interaction, un électron de l'atome peut recevoir de l'énergie : on dit que celui-ci est excité. Cette énergie lui permet alors passer sur une orbite électronique supérieure en énergie et plus loin du noyau seulement si l'énergie qu'il reçoit est égale ou supérieure à la différence d'énergie entre les deux orbites électroniques. On dit que l'énergie a été absorbée par l'électron sous forme de quanta bien déterminé. En effet, si l'énergie n'est pas assez grande, l'électron ne pourra se situer entre les deux couches ou orbites électroniques. L'énergie ne peut donc être absorbée que par "paquets". Les échanges sont quantifiés (voir histoire de la lumière). De plus, l'électron qui est passé sur une couche électronique ou orbite électronique, suite à une excitation par apport d'énergie, "veut" revenir à son état initial, c'est à dire sur son orbite électronique initiale. Celui-ci va donc y retourner en libérant un "paquet" d'énergie ou "quanta" d'énergie exactement égale à la différence d'énergie électronique entre les deux niveaux d'énergie ou orbites électroniques. Ces quantas sont des quantas d'énergie lumineuse appelée, grâce à Einstein, photons. Ainsi, l'énergie lumineuse libérée par les électrons d'un atome excité varie selon les orbites initiales et finales occupées par les électrons lors de l'interaction. Mais l'énergie lumineuse libérée par chaque électron aura une valeur bien déterminée et quantifiée. Or, à chaque énergie est associée une longueur d'onde et à chaque longueur d'onde correspond une couleur (par exemple une lumière de couleur bleue possède une longueur d'onde de 0,4 micromètre). Ce qui signifie que chaque électron excité qui retourne à son état fondamental émet une lumière colorée bien précise associée exactement à la différence d'énergie entre le niveau excité de l'électron et son niveau fondamental.

Si l'on prend une ampoule contenant de l'hydrogène à l'état gazeux et qu'on l'illumine de lumière, on va exciter tous les atomes de l'hydrogène contenus dans l'ampoule. Or, chaque atome d'hydrogène possède un seul électron. Sachant aussi que la lumière est composée d'une infinité de longueur d'onde donc d'énergies possibles, l'électron d'un atome d'hydrogène n'absorbera pas forcément la même quantité d'énergie que l'électron d'un autre atome. Ce qui signifie que les électrons des tous les atomes d'hydrogène ne vont pas occuper tous la même orbitale après excitation. En revanche, ceux-ci après absorption de l'énergie vont revenir à l'état fondamental commun à tous les électrons, en libérant, par paquets lumineux, l'énergie correspondant à la différence des deux niveaux initial et fondamental. Comme les électrons ne sont pas parvenus aux mêmes niveaux d'énergie, ceux-ci ne vont pas libérer la même énergie en revenant à l'état fondamental. Ainsi, les électrons revenant d'une orbite très éloignée ne vont pas libérer la même énergie que les électrons revenant d'une orbite assez proche de l'orbite fondamentale. Comme il n'existe pas un nombre infini de couches électroniques, les "paquets d'énergie" libérés par les électrons lors de leurs désexcitation, sont en nombre limité. Ainsi, comme à chaque "paquet d'énergie" correspond une lumière colorée, il existe donc plusieurs lumières colorées possibles et bien précises pour tous les atomes d'hydrogène contenus dans l'ampoule. L'ensemble des lumières colorées possibles émises par les atomes d'hydrogène s'appelle le spectre de l'hydrogène. Contrairement au spectre de la lumière blanche qui est continu car il possède une infinité de lumières colorées (ou longueurs d'onde), le spectre de l'hydrogène apparait discontinu : on observe des raies de couleurs bien définies. Chaque raie correspond ainsi au paquet d'énergie libéré par l'électron lors de son passage de son état excité à son état fondamental.

Spectre de l'hydrogène : spectre discontinu

Spectre de la lumière blanche : spectre continu

Il faut toutefois faire quelques remarques: chaque orbite électronique ou chaque couche électronique possède en fait plusieurs sous-couches électroniques, ce qui augmente les possibilités de transitions électroniques et donc d'énergies. De plus, nous avons considéré l'atome le plus simple qui puisse exister, l'atome d'hydrogène qui ne possède qu'un seul électron. Les autres atomes possèdent plusieurs électrons et peuvent en avoir un nombre assez important. il existe donc des interactions électriques et magnétiques, des couplages, qui augmentent la complexité du système atomique.

L'électron, une particule quantique : le modèle de Schrödinger

En ce début du XXème siècle, alors que Max Planck, Albert Einstein Niels Bohr introduisent de nouveaux concepts physiques comme les échanges quantifiés d'énergie, un physicien français Louis De Broglie (1892-1987) propose une théorie qu'il soutient lors de sa thèse en 1924 devant deux autres grands physiciens, Paul Langevin et Jean Perrin.

Dans cette théorie, De Broglie a pour point de départ l'effet photoélectrique découvert par Einstein quelques années plus tôt. L'effet photoélectrique stipule que la lumière peut être considérée comme une onde ou comme un grain de lumière c'est à dire une particule appelée photon.

L'idée de De Broglie est d'étendre à toutes les particules massiques infiniment

petites, l'association d'une onde ou d'un paquet d'ondes. Ainsi, pour De

Broglie, à un électron, particule massique élémentaire, peut être associée une

onde ou un paquet d'ondes. L'électron pourrait donc se comporter soit comme une

onde délocalisée, c'est à dire une sorte de vague électronique invisible et

étendue dans l'espace, ou bien comme un corpuscule, c'est à dire une

microscopique petite bille localisée et possédant une vitesse et donc une

quantité de mouvement bien précise. La matière aurait donc un aspect

ondulatoire !

Quelques années plus tard, deux physiciens américains, Davisson et Germer effectuent une expérience (l'expérience de Davisson-Germer) qui confirme la théorie de De Broglie. Cette expérience consiste à envoyer des électrons sur un écran fluorescent qui marque l'impact des électrons. Entre l'émetteur d'électrons et l'écran, est placée une plaque percée de deux fentes. Au début de l'expérience, les points d'impacts des électrons ont l'air de se distribuer aléatoirement sur l'écran. Or au bout de quelques temps, on voit apparaitre sur l'écran une figure d'interférences formée par les milliers d'impacts des électrons. On a donc une alternance de franges brillantes avec beaucoup d'impacts et de franges sombres, sans impacts. Tout s'est passé comme si chaque électron "savait où il devait aller" au moment de passer la fente traversée. Tout s'est passé aussi comme si l'ensemble des électrons émis s'était comporté comme des ondes lumineuses, puisque jusqu'alors, les figures d'interférences étaient seulement réalisables grâce à des ondes lumineuses depuis le dispositif de Thomas Young (voir histoire de la lumière).

Cette confirmation de la théorie de De Broglie lui vaudra le prix nobel de

physique en 1929. Mais plus qu'un prix nobel c'est un véritable bouleversement

qui s'opère dans le monde scientifique. En effet, comment imaginer un

électron capable de se comporter soit comme une onde ou soit comme une petite

particule? C'est impossible à concevoir et pourtant c'est ce qu'a imagine De

Broglie et c'est que nous a démontré l'expérience de Davisson et Germer.

Dès lors, la plupart des physiciens commencent à remettre en question leurs connaissances et leurs idées jusqu'ici basées sur les perceptions et le sens commun. C'est la véritable naissance de la physique quantique, une physique nouvelle, abstraite, qui dépasse l'entendement et l'imagination de tous, toute en restant extrêmement rigoureuse et précise grâce à de nouveaux formalismes mathématiques. En effet, à l'époque, le seul moyen de comprendre les nouvelles notions stupéfiantes et complexes de cet univers infiniment petit fut de lui associer un nouvel espace mathématique, un nouveau formalisme avec de nouvelles règles et de nouveaux postulats. Parmi ces mathématiciens physiciens on peut citer Hilbert, Dirac, Heisenberg et Schrödinger.

Dans la nouvelle approche de l'atome, les électrons sont donc maintenant considérés comme des particules quantiques, des "ondes de matière" qui peuvent se comporter soit comme une particule localisée soit comme une onde. En 1926, Un physicien autrichien, Erwin Schrödinger (1887-1961) introduit alors le concept de "fonction d'onde" pour caractériser chaque particule quantique. Elle apparait ainsi comme la représentation de l'état quantique de ces particules. De plus, Schrödinger établit l'équation la plus célèbre et la plus importante de la physique quantique : l'équation de Schrödinger. Cette équation décrit l'évolution dans le temps d'une particule quantique grâce à sa fonction d'onde.

Comme l'électron apparait comme une onde de matière délocalisée, il est donc impossible de le localiser précisément à un instant t précis. Cependant, grâce à la fonction d'onde introduite par Schrödinger, il est possible d'attribuer à chaque électron d'un atome, une densité de probabilité de présence de par la fonction d'onde propre à chaque électron. La localisation d'un électron en un certain point autour du noyau atomique apparait donc comme une probabilité déduite de la fonction d'onde de l'électron considéré.

Comme on ne peut plus considérer que les électrons ne tournent pas autour du noyau comme les planète autour du soleil, mais selon une densité de probabilité, on parle de nuage électronique pour décrire la présence des électrons autour du noyau : c'est le modèle actuel, le modèle introduit par Schrödinger et sa fonction d'onde.

Le modèle standard

L'antimatière